バーチャル3Dクリエイター神部まゆみです(*^_^*)

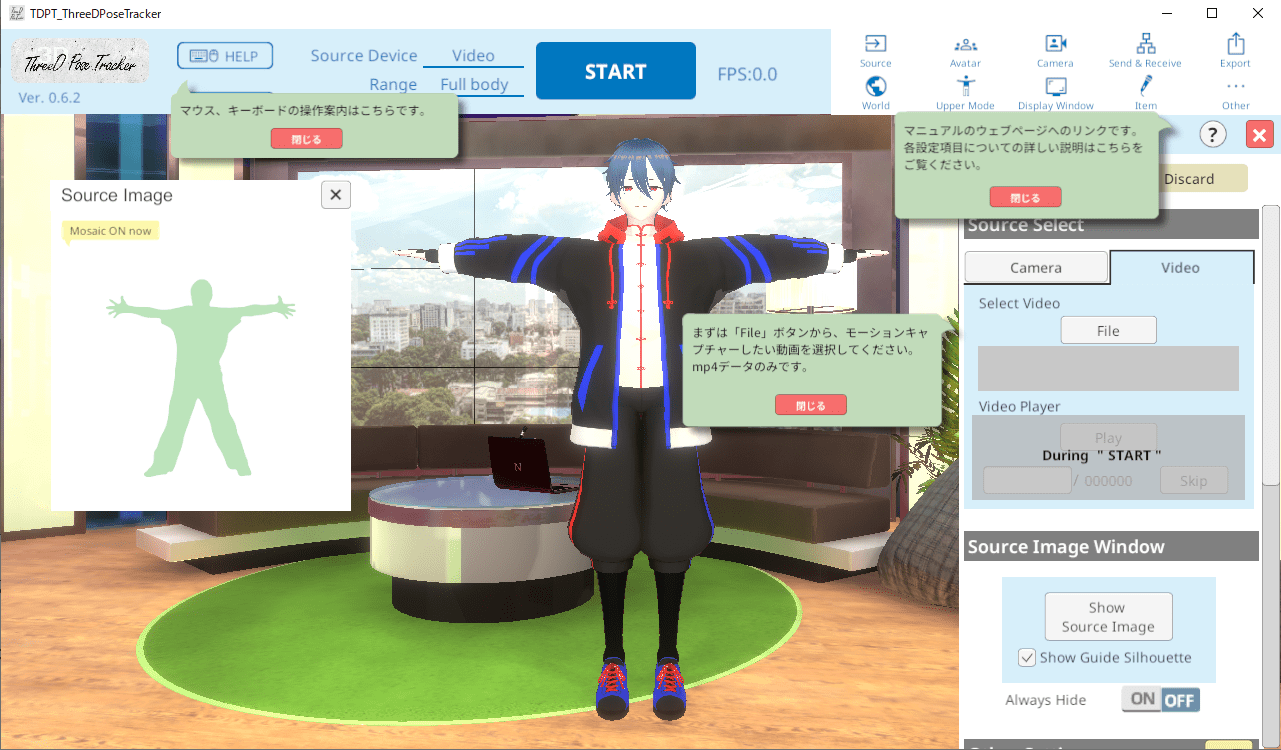

この記事はThreeDPoseTracker v0.6.2を使ってみたので、それについての記事です。

ThreeDPoseTrackerは前からちょくちょく触ってます。

動作確認した最新バージョンはUnity 6000.0.32 です。

ThreeDPoseTrackerとは

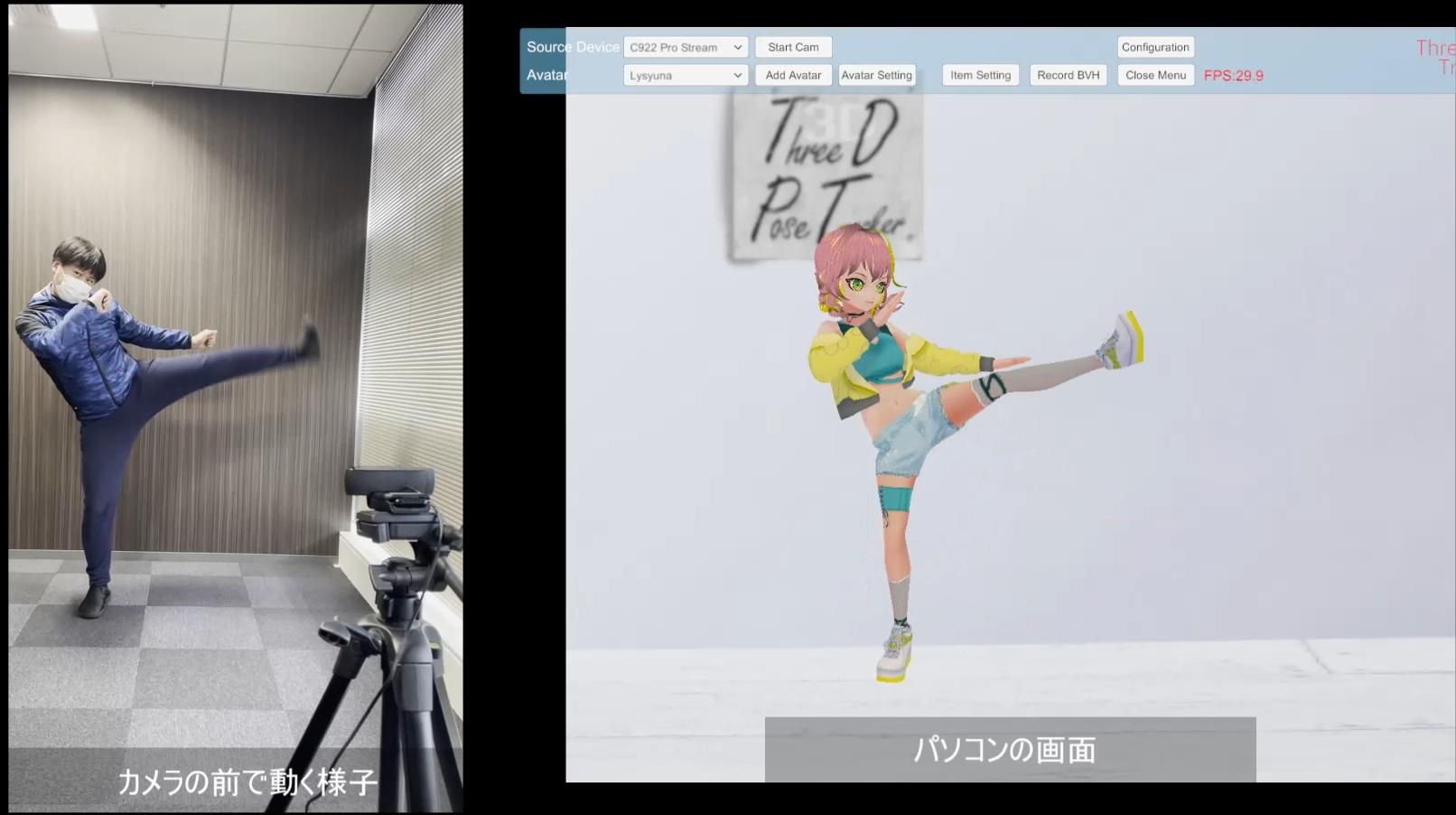

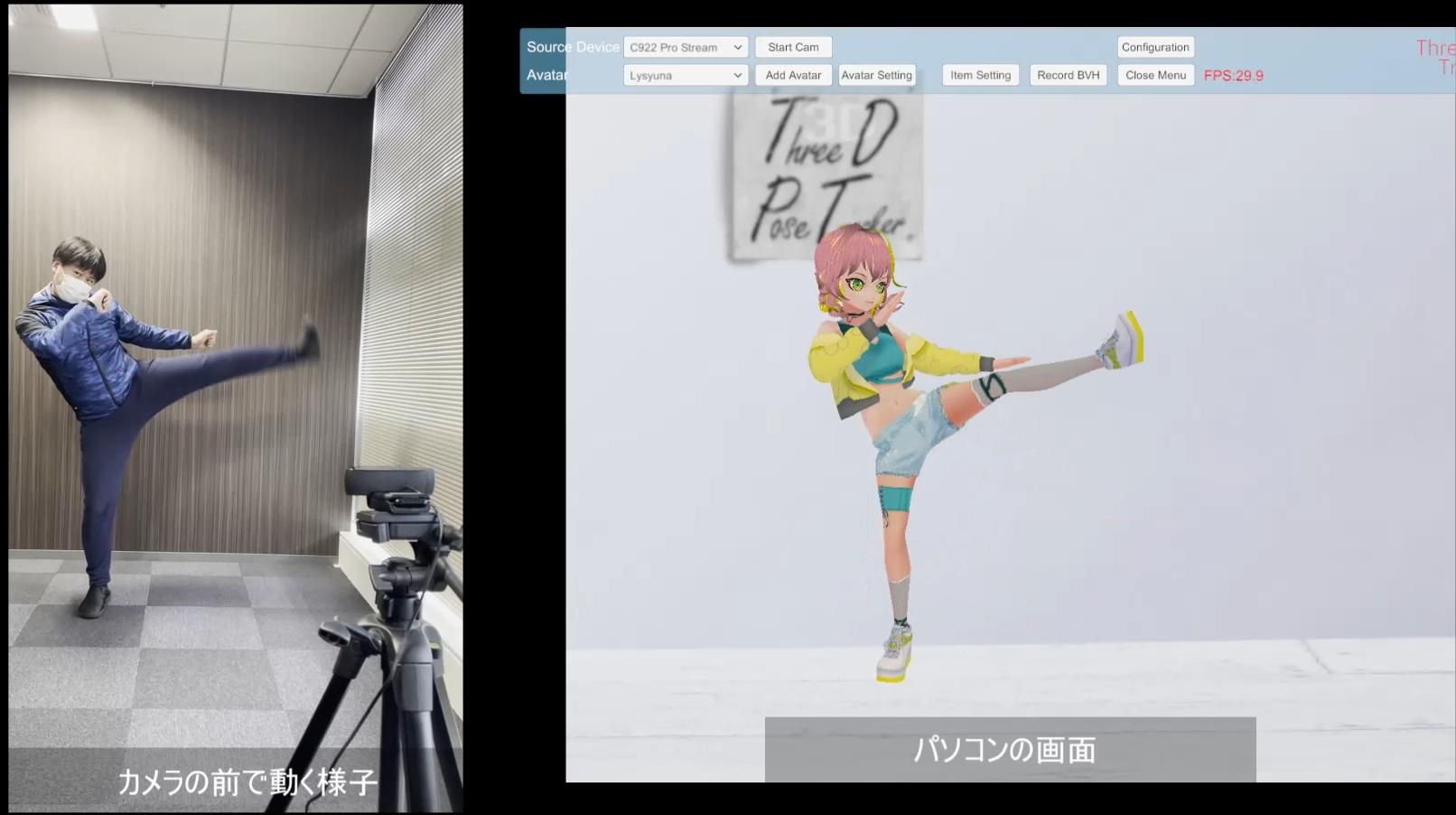

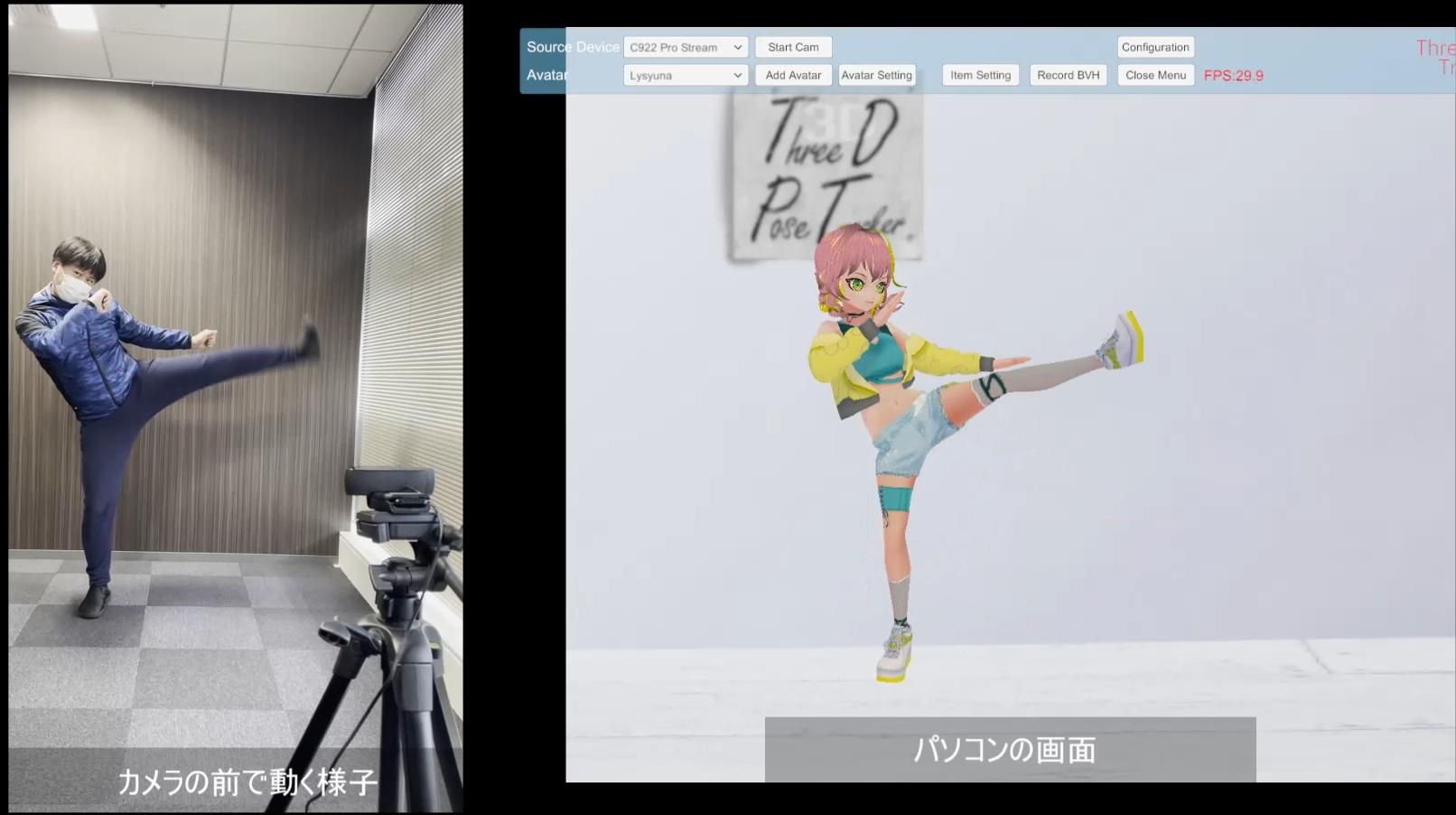

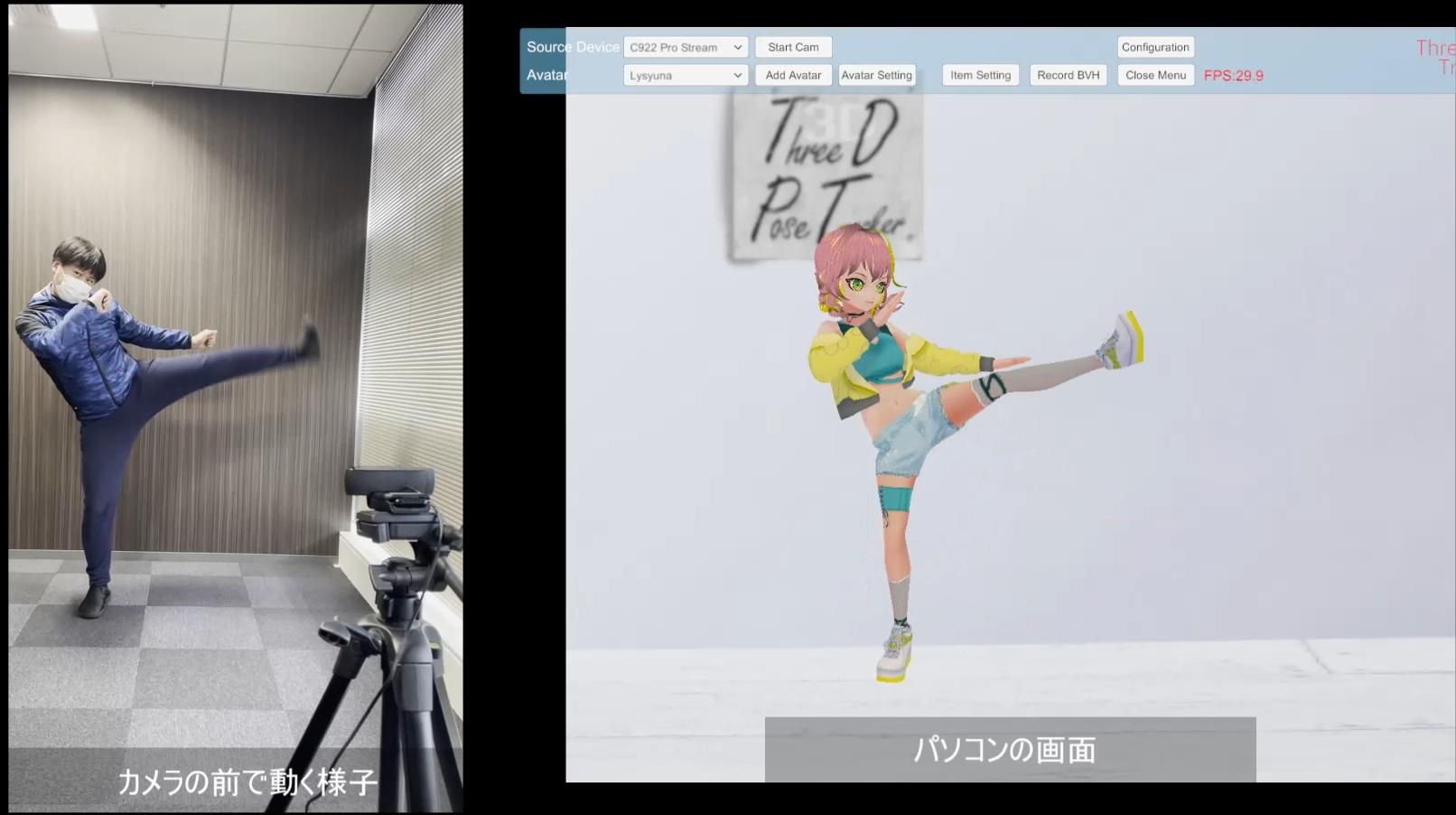

webカメラの映像や動画からモーションキャプチャーできるソフトウェア。

無料で使えるのに精度が高くてすごい。

どうも英語のコメントが多いみたいなので、海外の人からも人気のようです。

先輩たちの作例など

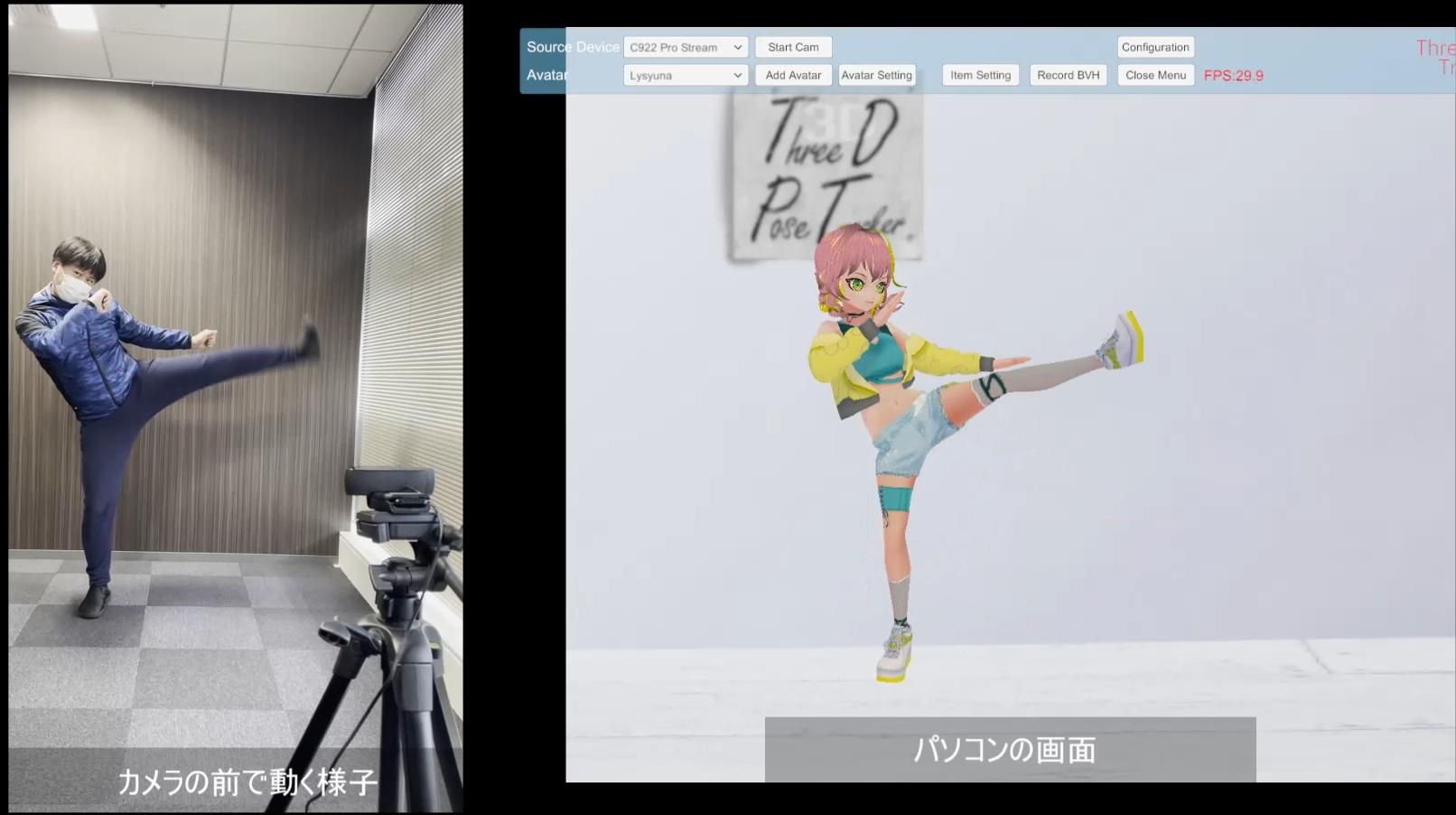

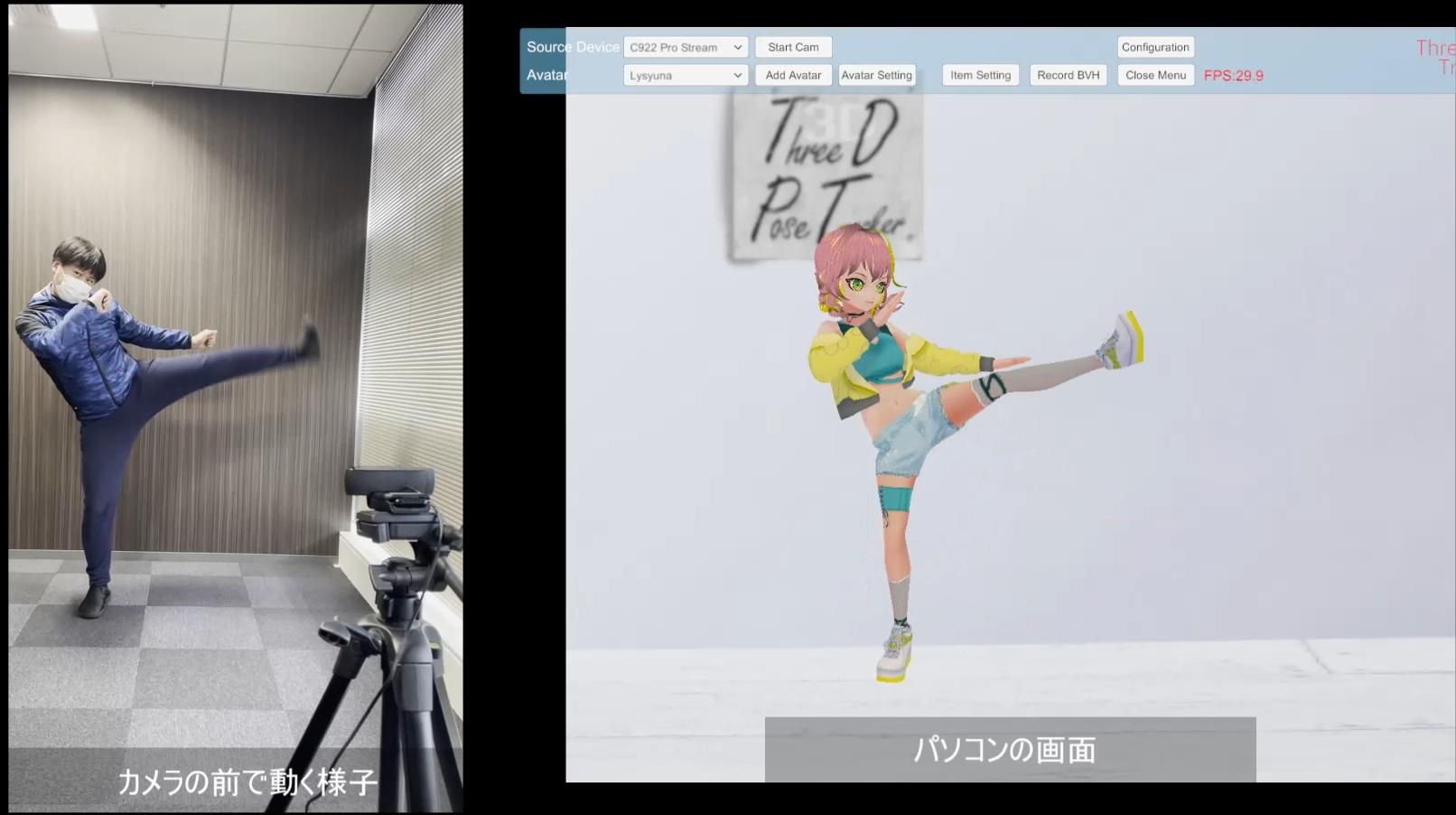

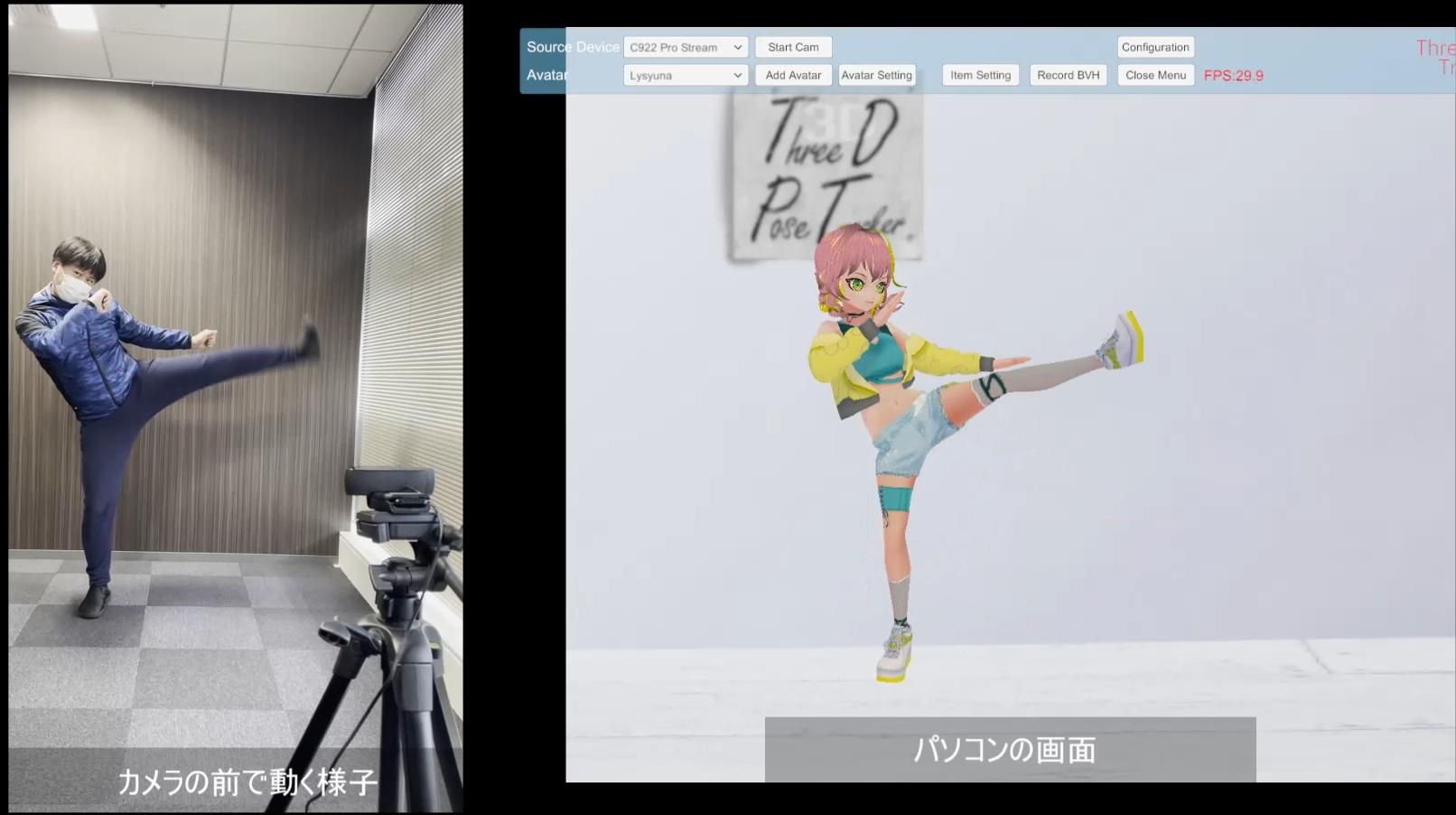

これはTDPTの作者さんのやつですね。

MMDの話があったので、次のVer0.6.1のVMDのテスト動画。#TDPT

— yukihiko_a@TDPTの人 (@yukihiko_a) December 13, 2023

VRM→PMXは、@miu200521358 samaのVroid2Pmxを使ってます pic.twitter.com/QQzAedqNJv

こちらの先輩もTDPTのタグがついてるからたぶんそうかな?

こんばんはにございます!(^^)!

— 小山芳姫@小山の鷲城の姫 (@1000Roku) October 27, 2024

芳姫鷲神社で迷惑ダンスを踊るよこしまな人が!#TDPT #煌御門碧琴 #小山芳姫 pic.twitter.com/VvDwvky1fz

こちらの先輩のダンスもかなりの精度で検出していますね…。慣れてる人がちょっと編集すればいけそう。

※このまま使う完成度ではありません。

— ほたるん【Vtuber】くそげーを愛する会 (@princesshotaru) June 20, 2024

ダンスのベースにして修正して完成させてくれたらうれしいhttps://t.co/TNrisXII88#TDPT pic.twitter.com/HcDc353xq8

んー普通に精度高いな…やはりカメラとか撮影環境が重要な気がする。

瞬間的に超暇になったので、#TDPT で『スイートプリキュア』の

— マグナム (@magnumjr2) June 19, 2024

『#キボウレインボウ#』を作成。

踊っているのは中山兄貴@jkdmania のチームでキュアリズムをやられていたお姉さんだ!

撮影は前のモーション撮影の時にやったんだけど、出すの遅くなっちった。

ダンスの方がモーション反応良いかも pic.twitter.com/Zjb20qSphx

こちらの先輩も触れているけど、やはり背景は重要っぽい。白背景で色つきの服だと人間でも見やすいし。

TDPTを別なダンスで試してみた♪(#^.^#)

— 虹色画房♥(虹色音房)🌈【創作垢フォロバ💯】 (@maki7733) June 16, 2024

今度は30FPSほぼ張り付き!

って事は・・・

背景が関係あるのかなー

背景がシンプルだと好結果に繋がると言うか。 pic.twitter.com/pj8AdPBW0e

やはり白背景に黒い服とか、くっきり分かりやすい感じにするとかなり精度高そう。

今更ながらちょっと解説。#cluster の皆にはもうお馴染みだけど、

— マグナム (@magnumjr2) March 10, 2025

俺たちは #TDPT ってアプリを使って

アクションをVRMのアバターに反映させてるんだ。

3/20のガイファングは、当時のアクターだったしらす@pawasira が

再びガイファングを演じるぞ‼︎

アバター×スーツアクターのアクションは必見! pic.twitter.com/vp05p5uGpC

「TDPT ダンス」「TDPT MMD」とかで検索すると先輩たちの作例がたくさん見つかります。

さっそく使ってみる

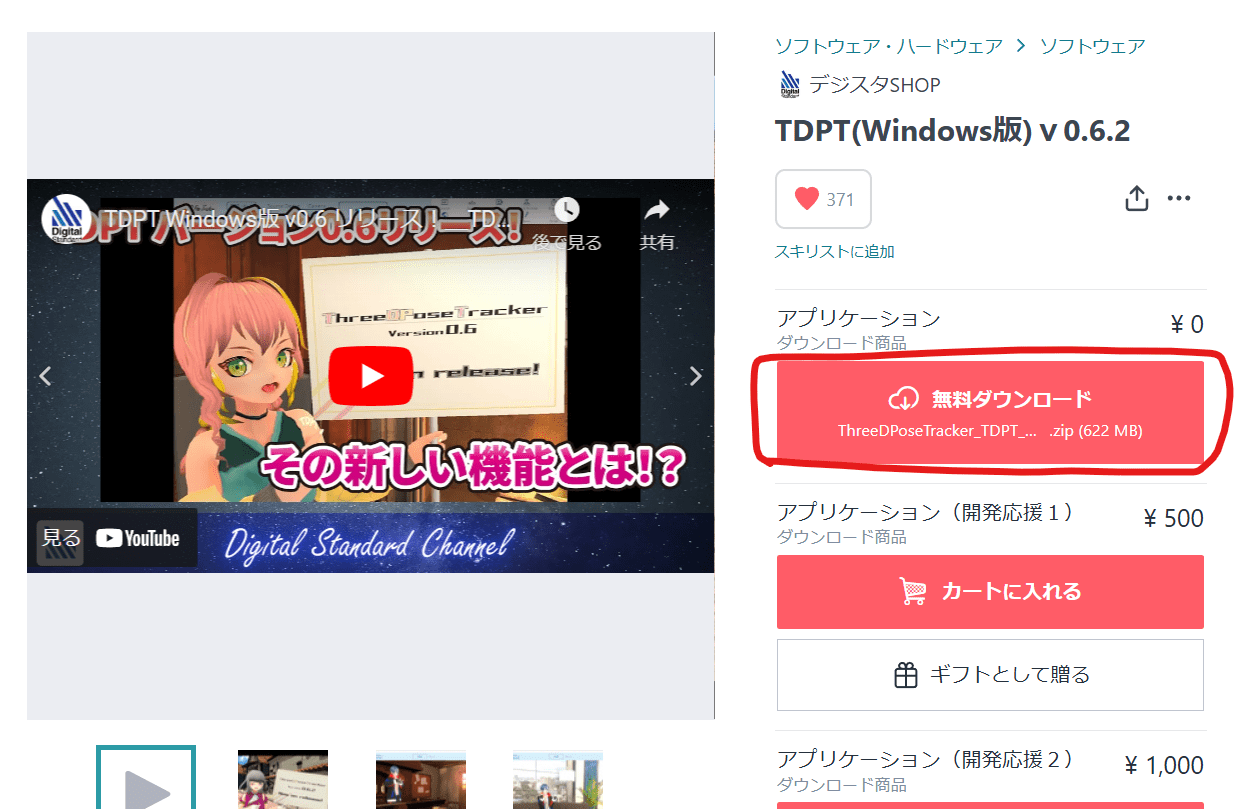

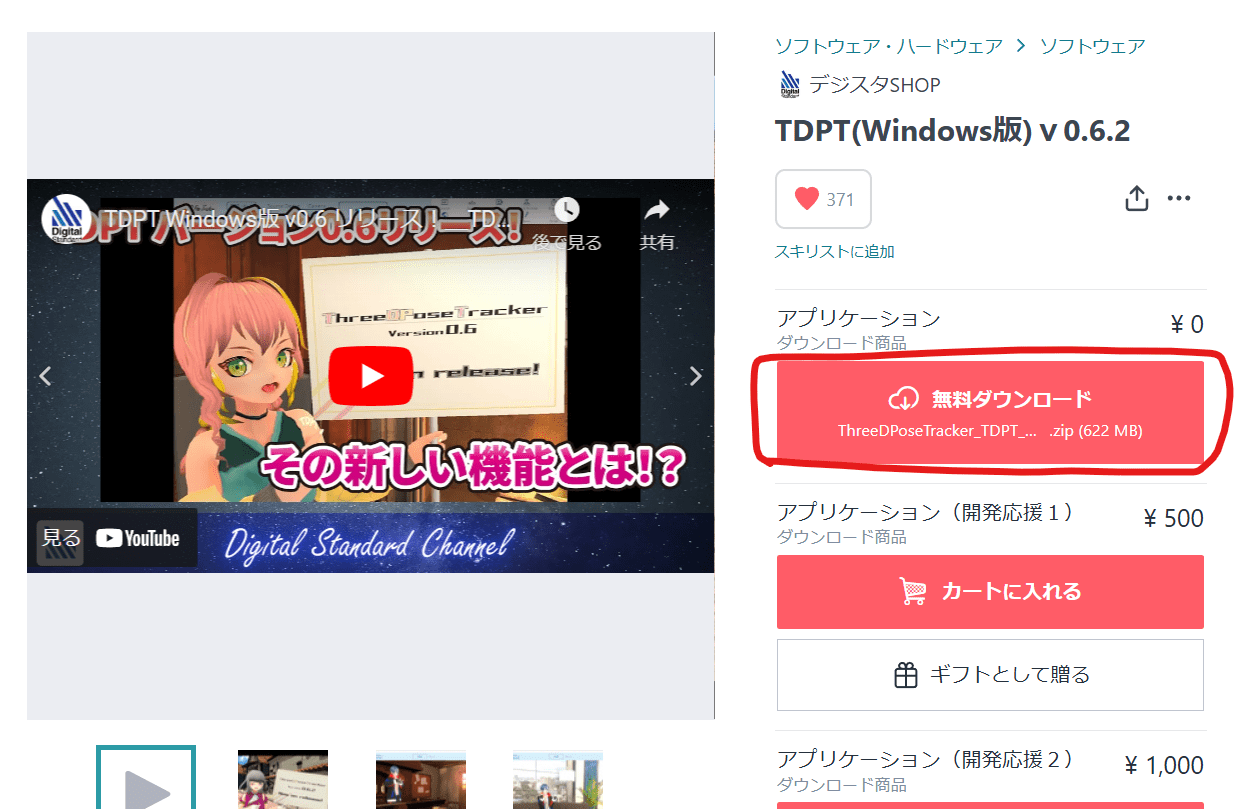

こちらからダウンロードできます。v0.5とはページが変わっているみたいなので注意。

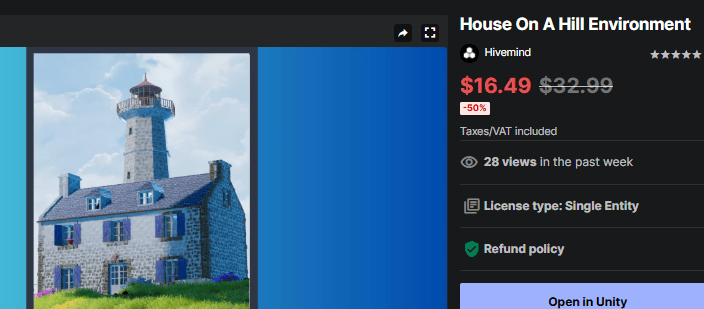

無料で使えるけど、応援版を買うと作者さんのアップデートのモチベーションが上がるかも?(;^_^A

無料でダウンロードできるけど、開発応援版を買えば作者さんのアップデートの励みになるかもしれません。

今は有能なエンジニアの方は引く手あまただから、こういうフリーソフトにコミットしてくれるのは貴重ですね(^_^;)

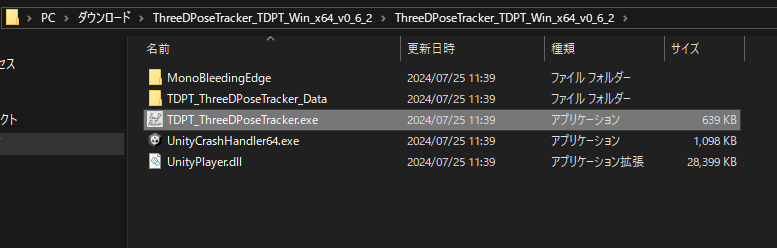

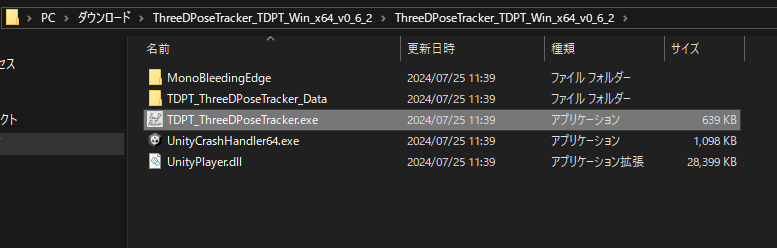

ダウンロード後zipを解凍、 TDPT_ThreeDPoseTracker.exe を起動すればOK。

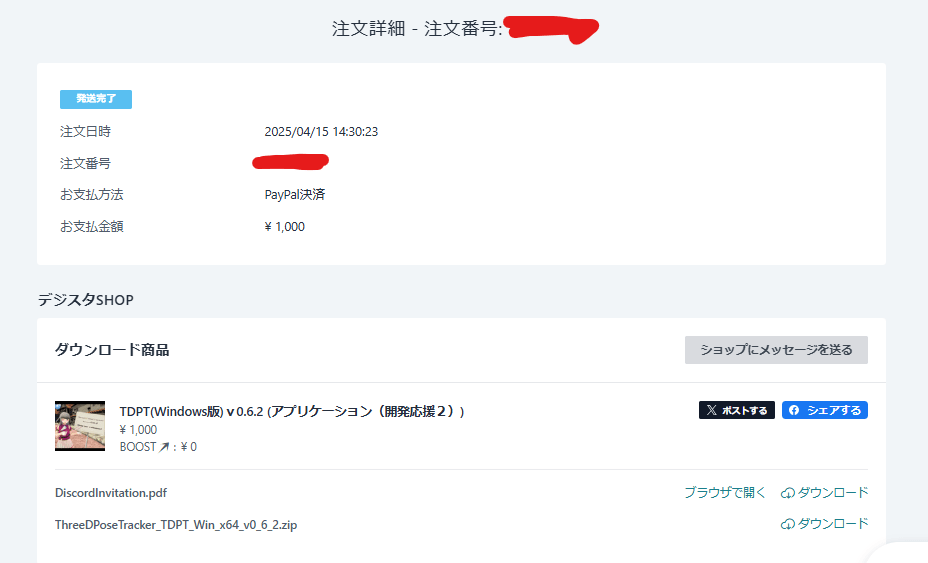

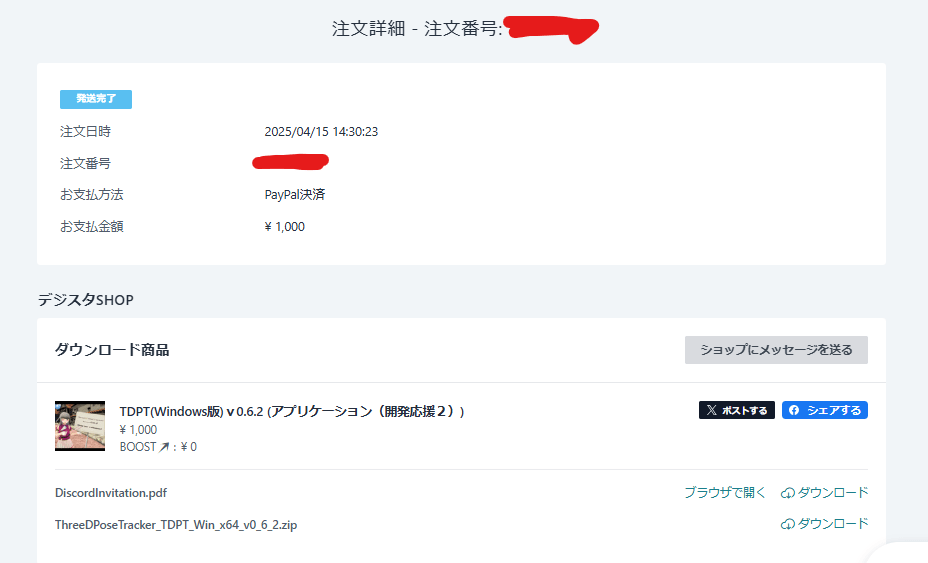

せっかくなので開発応援版を買ってみる

いくつか画像認識系のモーションキャプチャー使ってみたけど、結局TDPTの精度の高さを再確認する感じになったかな…。

フリーソフトはアップデートされなくなることも多いため、開発応援版を買ってみます。まぁ1000円ですが(;^_^A

開発応援版だとDiscordの招待状も入っているので、サポートや改善要望なども聞いてもらえるかもしれません。

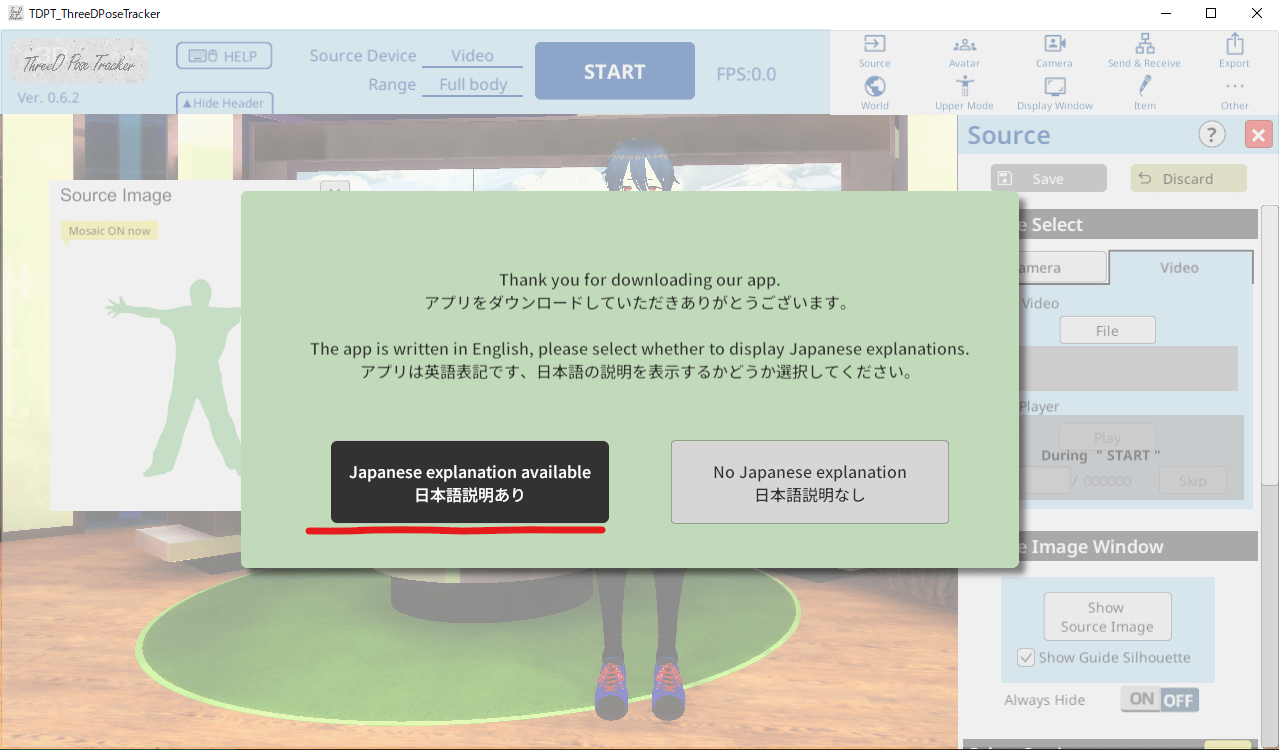

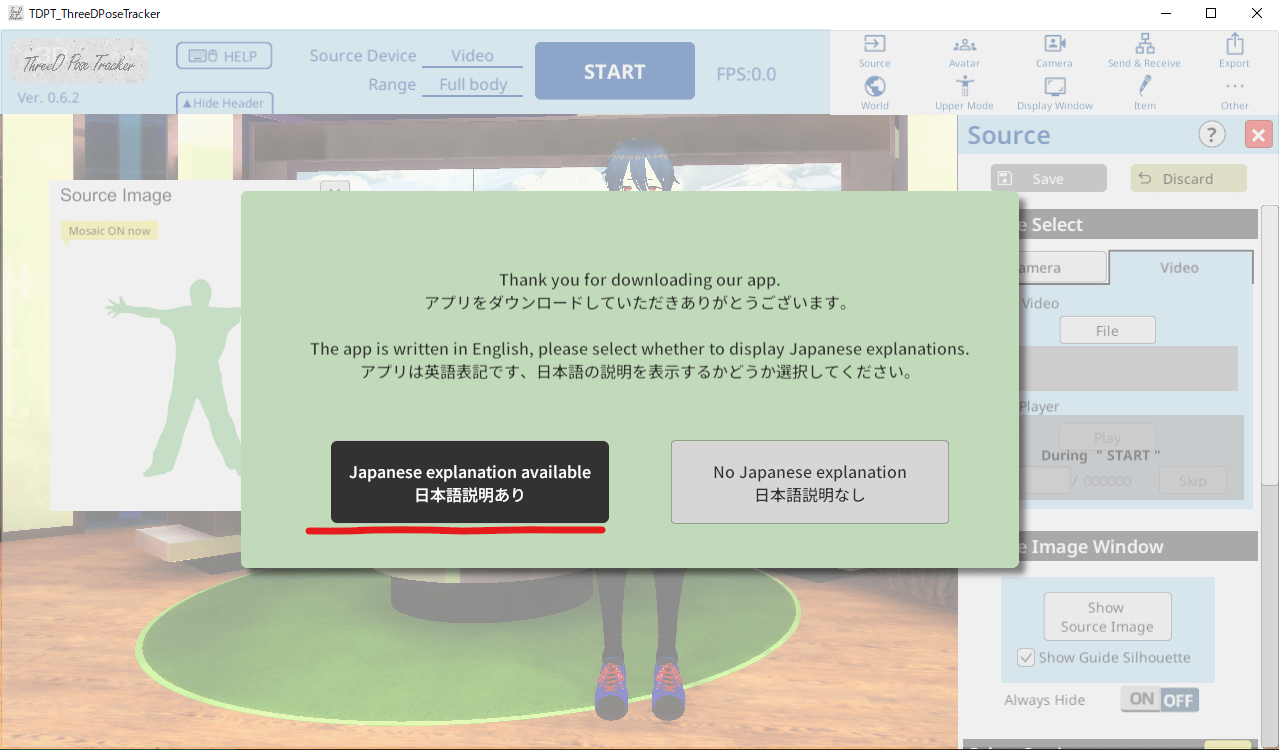

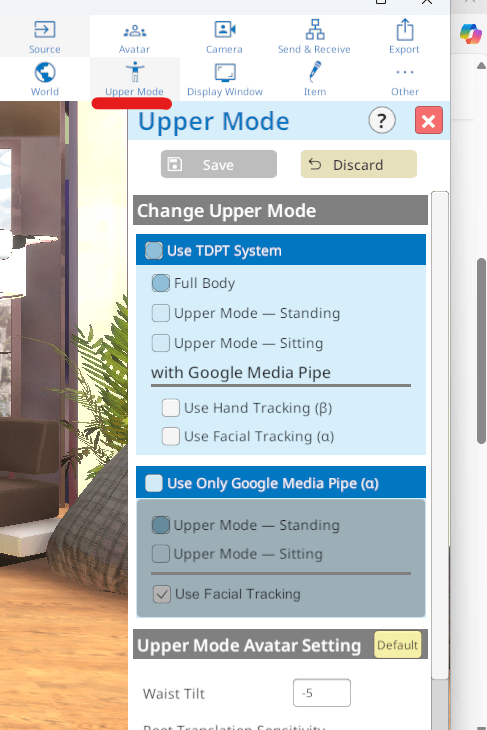

さっそく起動してみる

起動したら日本語の説明をつけるかってウィンドウが出ました。「日本語説明あり」を選んでおきます。

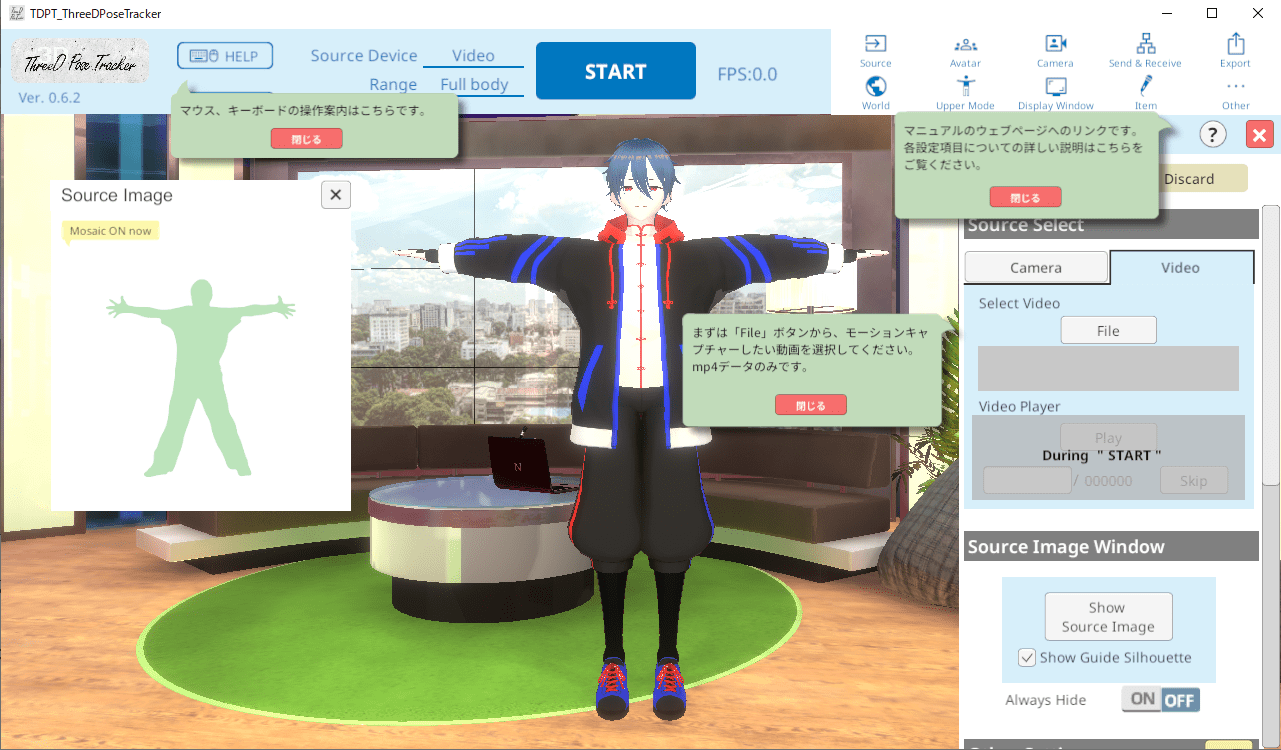

おお、なんかメニューが増えた?気がするΣ(゚Д゚)

とりあえず簡単な操作方法とか

公式の説明マニュアルがあるので詳しくはこちらを見たほうが早いかも。

とりあえず基本的なことだけやってみます。

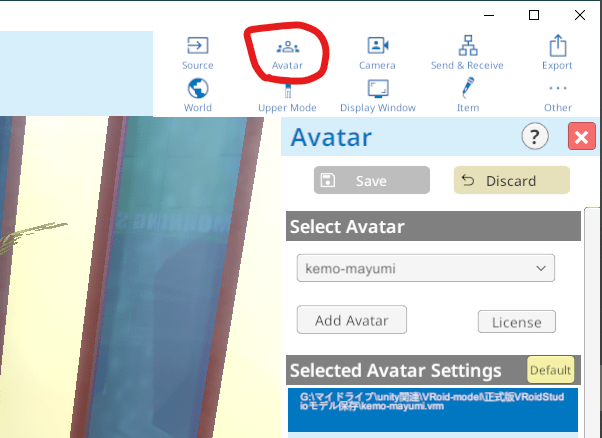

アバターを変える

Avatarメニューを開き、Add Avatarからアバターを選びます。

VRM1.0モデルにも対応してるっぽい。

これでアバターを読み込めました。

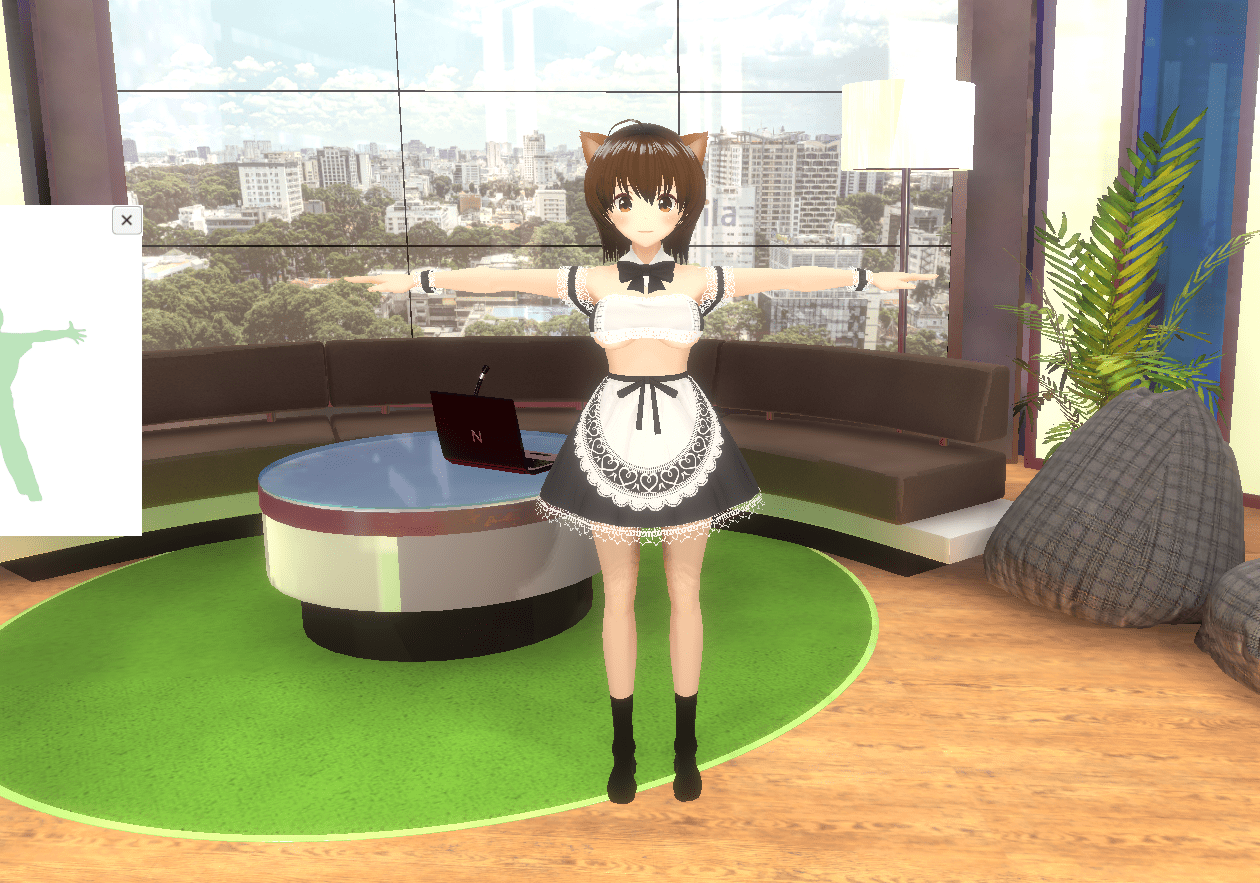

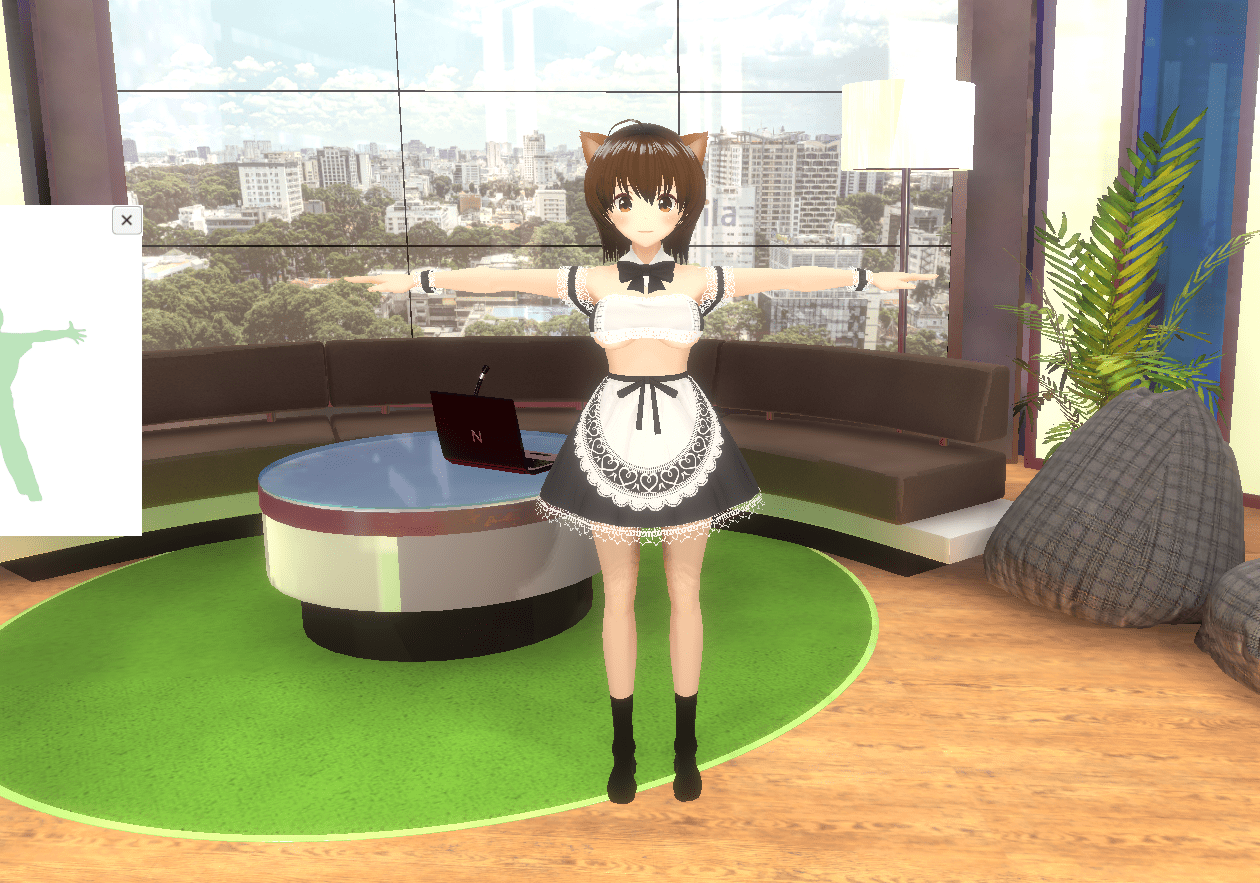

背景を変える

Worldメニューで背景とかも変えられます。

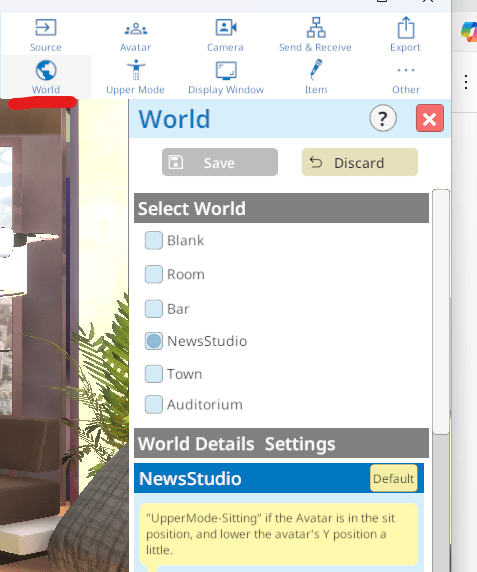

ハンドトラッキングや表情トラッキングの設定をする

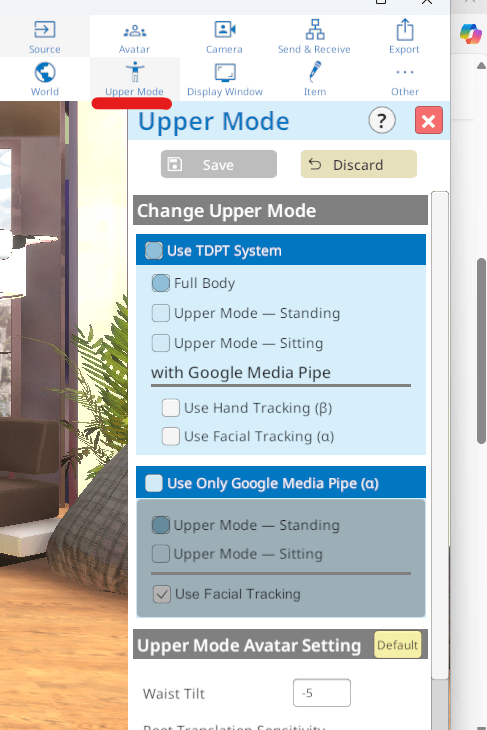

Upper Modeメニューでハンドトラッキングや表情トラッキングの設定もできます。

これ全身モードでもつかえるみたいだけど、私のカメラは720Pなので精度はちょっと低かったですね(^_^;)

しかしカメラから離れると高解像度のカメラでも細かい表情まで検出するのはちょっと厳しいかも?

まぁ配信とかで使うなら上半身モードでカメラに近付いて使うようにして、モーションとして使うなら手動で表情付けた方が良いかもしれない。

VMC Protcol対応なのでモーションキャプチャデータをUnityやVRChatに送ったりできる

ThreeDPoseTrackerはVMC Protcolに対応しているので、モーションキャプチャデータをUnityやVRChatに送ったりできます。

↓はXR Animatorだけど、EVMC4Uを使ってUnityでモーションキャプチャを動かしたりできる。

しかしVRChatは動いたものの、動きがかなり変な感じになってしまった。

設定をいじる必要があるかもしれません。

youtube動画でキャプチャーする

前回と同じこの方のラジオ体操動画を使わせてもらおうかなw

字幕が入っている部分はちょっと検出できなくなったけど。

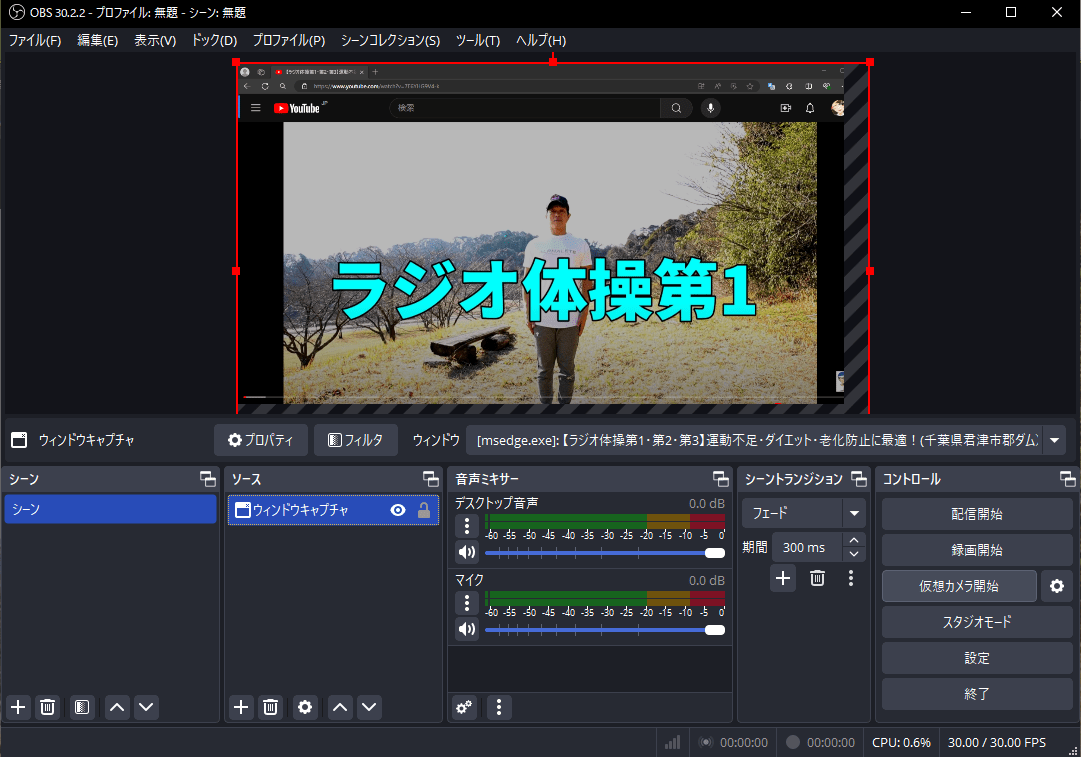

OBSを使ってウィンドウキャプチャしたら使えた。

ウィンドウキャプチャを選択して、youtubeを流しているウィンドウを指定する。

youtubeを開いているタブを新しいウィンドウで開いたほうが指定しやすいかもしれない。

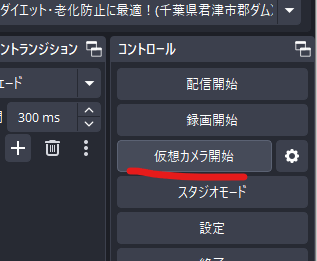

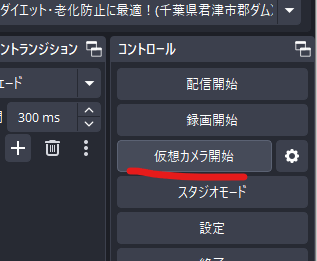

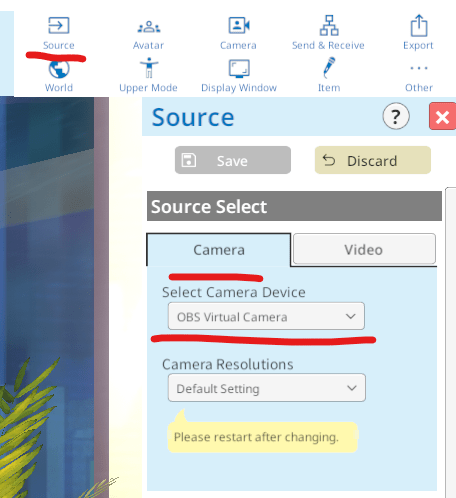

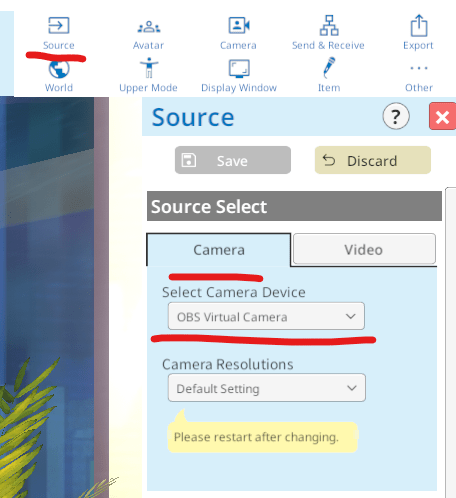

これで「仮想カメラ開始」を押したらOBSでキャプチャ↓画面をwebカメラの検出として使えるっぽい。

これでできた!

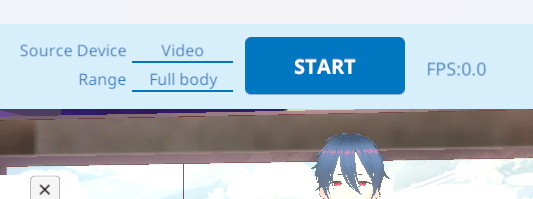

向かって左の、緑色の人間のシルエットのあたりになるように調整すると良いっぽい。

まぁ動画は字幕が入っていたりするから自分でカメラや動画撮影して撮ったほうがいいけど。

webカメラから録画してBVHファイル保存、FBXに変換してUnityに持っていく

せっかくなのでwebカメラから録画してBVH保存してみます。

それをFBXに変換してUnityに持って行ってみる。

録画してBVH保存する

上のStartボタンを押すとモーショントラッキングが始まります。

↓ExportメニューからRecordingできます。Webカメラの様子は恥ずかしいのでカットで…w

パンチとかは横向きでやったほうが良い感じに検出できましたね。

blenderでインポート、位置合わせをしてFBXエクスポートする

最初にあるキューブやライトを全部削除してインポートする。

なんか倒れてるけど修正します。

これもしかしたらTDPTの設定で直せるのかな?

とりあえず正面を向かせて位置合わせし、全トランスフォームを適用、原点も調整しておく。

FBXでアーマチュアだけエクスポートします。

Unityに持って行って設定する

Unityに持って行ってHumanoidにします。

その後△のアニメーションクリップをCtrl+Dで複製、モデルに適用します。複製しないとアニメーションの編集ができずReadOnlyになっているため。

アニメーションファイルの設定は、私が使っているアセットのVeryAnimationの推奨設定が ポーズにベイクをチェック 基準=元 だったから惰性でこれにしてます。ここの設定で見え方が変わるので不具合があればいじるかもしれない。

BVHをFBXに変換してUnityに持っていく方法は以前記事を書いたので詳しくはこちら。

これでUnityで動いた!

これで動きましたね!かなり精度が高いです!Σ(゚Д゚)

余分な部分を削除する

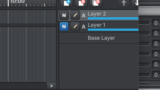

私はVeryAnimationを使っているので、トリムツールで簡単に余分な部分を削除できます!

デフォルトだとどうやるんだろ、ちょっとわかんないっす(^_^;)後で調べておくかも。

Unityでアニメーションを編集するなら、VeryAnimationかUmotion Proあたりを持っている人が多い気がします。

浮いた足を上手く接地させる方法など

現状だとRootの関係でちょっと足が浮いていたけど、足IKのスクリプトで上手く接地させられました。

良い感じに編集する方法など

Umotion ProっていうUnityアセットはレイヤーが手軽に使えるので編集しやすいです。

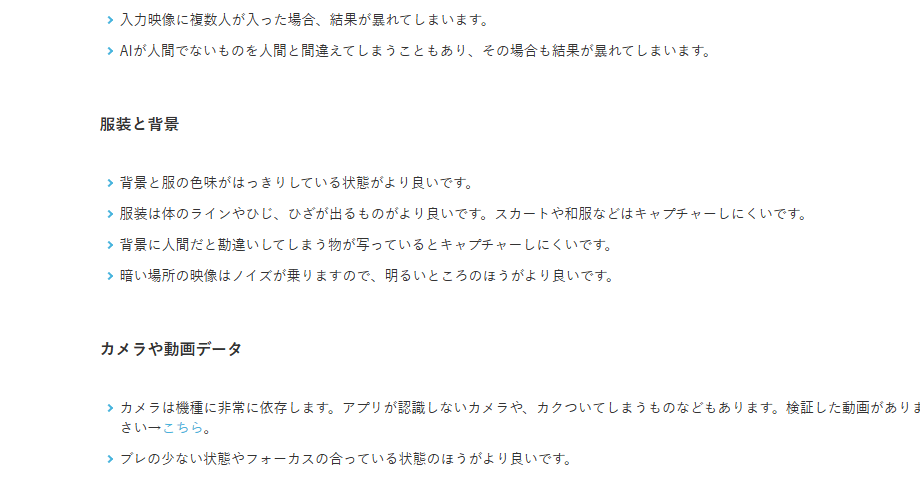

良い感じにするコツなど

良い感じにするコツなどを調べたので書いておきます。

撮影場所の明るさや背景に気を遣う

これが一番重要かな?後ろの壁が黒で服も黒だと認識できないと思う。

youtubeの体操やダンスの動画とかは、屋外だったり明るくて広いスタジオとかで収録されているから認識率が良い気がする。

三脚を持って公園にでも行って動画を撮ってくるのが一番良いかな?

検出しやすい服装にする

背景の色合いとの相性もあるけど、スカートやダボダボした感じの服だと検出しにくいです。

これは公式マニュアルのページに載っていますね。

屋内でやるなら垂れ幕みたいなの用意して、できるだけ薄着で肌が見えるようにやった方が精度が高くなった気がする。

暗い感じの壁で黒に近い服だとぜんぜんダメでしたね(^_^;)人間が見て分かりにくい色だと、TDPTも検出できないようです。当たり前だけど。

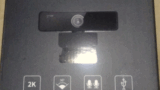

高解像度の広角カメラが良いっぽい?

視野角が大きいほうが良いっぽい?これ部屋が狭くても広角だと広い範囲を映せるので都合が良いと思う。

私はそんなもの持ってないのでダイソーに売っていた広角レンズをwebカメラに付けているけどw

↓こちらの優秀な先輩によると、割と有効な手段っぽいですね。

webカメラの全身モーションキャプチャーお部屋の広さ問題で出来ないってお話をよく聞きくのでCoCoNo流裏技を少し😋

— CoCoNo⌘【VirtualDroneDrummer】 (@izmtai) March 25, 2025

スマホに付けるクリップタイプの広角or魚眼レンズ❣

私のはガラスレンズだけどプラのなら100円ショップでも売ってるよ✨

カメラからの距離1m‼

XRAとTDPT普通に使えました😊 pic.twitter.com/wU1Y5B74LW

あとダイソーのフレキシブルアームでwebカメラを挟んだら位置や高さ調整がしやすかったです。

私のカメラは720Pの低解像度だけど、まぁまぁ認識できてるからこれで十分かな…。

最近は1080Pの広角カメラも3000円くらいで売ってるので買っても良いけど、TDPTくらいにしか私の場合は用途がないっす(^_^;)

もしくは手持ちのスマホのカメラは割と視野角が広めだったので、録画して読み込ませるのもいいかもしれない。

追記:なかなかの性能のwebカメラが数千円で売ってたので買ったら精度が全然違ったΣ(゚Д゚)

↓Amazonのセールで3000円以下でなかなかの性能のwebカメラが買えたけど、精度が全然違いましたΣ(゚Д゚)

精度が低い場合、TDPTの問題ではなく入力側を疑ったほうがいいですね…。

手足が体に隠れないほうがいいかも?

これ画像認識だから、手足が隠れてしまうと認識できずにあらぶりがち。

特に横を向いた時とか、座ったり立ったりする時に荒ぶるリスクがある。

しかしそこさえ気をつければ割としっかり認識してくれる。

↓みたいな感じで常に手足を見せるようにしたら座るモーションでも良い感じに認識できた。

モーションとして使う場合は手足一か所だけとかなら後で修正しやすいので、このくらいなら後で修正すればそんなに手間にはならないと思う。

上半身モードだとかなり精度高い?ので割り切って使うのも良いかな?

上半身モードだと指の検出精度もかなり高いので、上半身だけ動けば良いなら十分かもしれない。

Faceトラッキングはそのままだと目があらぶってしまったから、設定見直したり更に気を遣う必要があるかも?(;^_^A

まぁモーションとして使いたいだけなら後付けでやればいいかもしれない。

つづく?

良い感じにモーションキャプチャーできて良かった。

VTuberの人が配信に使うとかなら、正直このくらいで十分かな?

リップシンクやハンドトラッキングもできるし。

モーションとして使う場合もこれだけの精度が出れば割と使いやすいと思います。

あとは編集するスキルとかを磨いた方がいいかな?

ちょっと編集の仕方とかをメソッド化してまとめてみたいかな。

まぁもう少しいじってみます(*^_^*)